Ukens notater #20: Kollektiv DeepSeek-panikk

Den siste uken i teknologi har stort sett handlet om en ting, DeepSeek. Det har blitt skrevet spaltemeter opp og ned om DeepSeek. Du kan rett og slett ikke ha unngått å få med deg DeepSeek i uka som gikk, men sitter man igjen med et korrekt inntrykk? Det virker som vi har fått kollektiv panikk. Til Dagsrevyen ga DeepSeek mer enn 5 minutter sendetid og heldigvis, heldigvis tok hele Norges AI-ekspert Inga Strumke det ned et par hakk live på NRK.

«Jeg må starte med å korrigere inntrykket. Dette har ikke revolusjonert KI-verden» - Inga Strumke på NRK Dagsrevyen

Vi trenger stemmer som Inga Strumke når hypen og panikken tar overhånd. DeepSeek har på ingen måte revolusjonert AI. Dette er språkmodeller som kan måle seg med flere av de mest avanserte modellene fra OpenAI, Google, Antrophic og Meta. Det kalles konkurranse. Allerede i 2023 ble et internt notat fra Google lekket hvor flere av de som jobbet med AI i Google hevder at verken Google eller OpenAI har noe «moat». De mente at Google, OpenAI og andre lukkede AI-modeller har få «forsvarsverk» mot de åpne modellene som f.eks. Llama fra Meta. Det er det DeepSeek viser enda tydeligere nå. En åpen modell kan komme like langt som en lukket modell.

Det som er mest overraskende er at et kinesisk selskap som sliter med tilgangen på de heftigste GPUene fra Nvidia på grunn av eksportkontroll har kommet så langt såpass fort og dette er nok årsaken til den kollektive panikken. Her er det nok også noen sannheter med modifikasjoner. DeepSeek har brukt mer enn 500 millioner dollar på GPUer, de har sannsynligvis fler og bedre GPUer enn de sier og foreløpig kan det se ut som de også har misbrukt OpenAI sine modeller til å trene egne modeller.

Men det de utvilsomt har greid og som er det mest spennende med DeepSeek, er at de på grunn av sine begrensede ressurser har blitt kreative. De har introdusert en rekke nye konsepter som gjør det enklere, billigere og mer energieffektiv å bruke disse modellene. Disse konseptene er nå åpen kildekode og hvem som helst kan benytte seg av de. Nvidia har foreløpig vært selskapet som har tjent mest på AI-boomen, men deres inntekter er også tett korrelert med at det trengs fler og fler GPUer for å trene bedre og bedre modeller. DeepSeek sin innovasjon stakk kanskje en hull på den boblen.

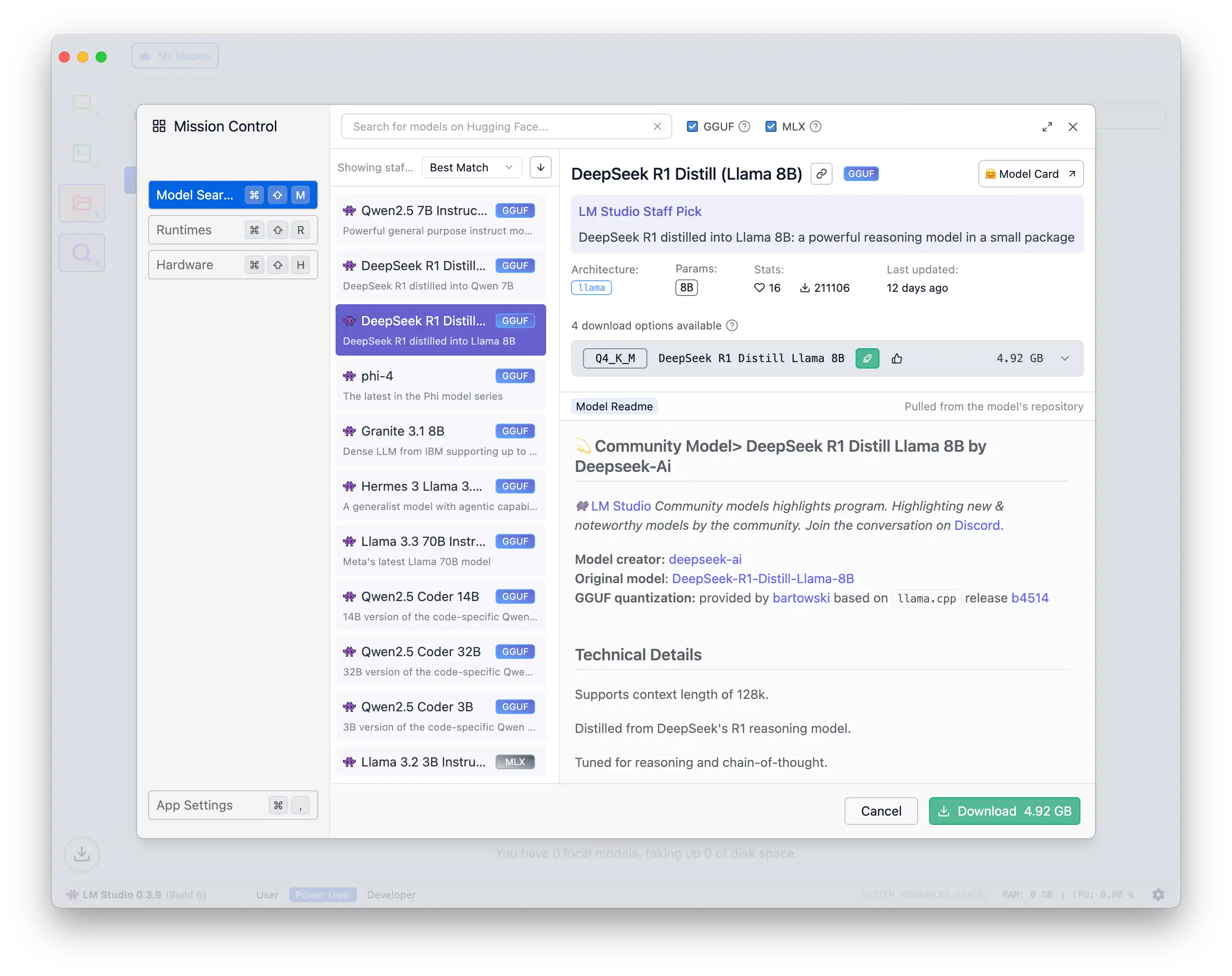

DeepSeek som en tjeneste, dvs. appen du laster ned eller bruker på web, lagrer alt du skriver og deler med DeepSeek i Kina. Det er åpenbart problematisk, men DeepSeek har også sluppet den mest avanserte R1-modellen som åpen kildekode. Det betyr at du og jeg kan kjøre denne lokalt på våre datamaskiner og dermed ikke være bekymret over informasjonen som lagres i Kina. Den vil kun lagres på din egen datamaskin. Jeg har satt opp DeepSeek R1 på min egen Mac og laget en liten guide som viser deg hvordan du gjør det.

🤖 AI

- Move over DeepSeek. Amerikanske Ai2, også kjent som The Allen Institute etter Microsoft-gründer Paul Allen, lanserte AI-modellen Tülu 3. Denne skal slå både DeepSeek v3 og ChatGPT 4o i en rekke benchmarks og ulikt begge er den lansert under helt åpen kildekode. Hastigheten på utviklingen innen åpne modeller går nå veldig raskt.

- Etter DeepSeek er det et åpent spørsmål om eksportkontrollen av GPUer fra Nvidia til Kina egentlig fungerer. Dario Amodei, gründer av Anthropic og tidligere Head of Research hos OpenAI, mener i et essay at eksportkontrollen er viktigere enn noensinne for å sørge for at demokratiske land når AGI før kommunistpartiet i Kina. Dario meler åpenbart sin egen kake noe, men hvis man tror at vi er på vei mot AGI har han sannsynligvis også rett.

- Her er 1150 spørsmål som DeepSeek ikke vil svare på

- Det er ikke alltid like lett å få gode svar ut av AI-modellene, men dette er en god guide til hvordan du bedre kan jobbe med LLM og tekst.

- John Siracusa skriver godt om AI og utfordringene med opphavsrett i «I made this»

- Sjefen for Googles DeepMind og Nobelpris vinner Demis Hassabis snakker om veien til AGI i dette intervjuet. Verdt en titt.

- OpenAI viler heller ikke på laurbærene og lanserte fredag o3-mini som er en mindre og rimeligere modell enn o3 som har kostet $200 i måneden å få tilgang til. O3-mini er fininnstilt for STEM-problemer, spesielt innen programmering, matematikk og naturvitenskap.

🌎 Big Tech

- De siste årene har Apple litt i det stille lagt til støtte for satellittkommunikasjon rett fra iPhone når man befinner seg i et område uten dekning. Dette har vært begrenset til tekstmeldinger og nødanrop. Men nå utvides dette. Sammen med T-Mobile har Apple utvidet satelittfunksjonaliteten til å nå også støtte Starlink. Dette er både en stor mulighet og en stor trussel for telcos.

- Marquese Brownlee har fått teste Samsung sin Vision Pro-konkurrent, foreløpig kalt «Project Mahun». Hardwaren ser ut som en direkte kopi av Vision Pro og det virkelig spennende er dermed softwaren - Android XR - Googles variant av visionOS.

- Meta har inngått en avtale om å betale 25 millioner dollar for å avslutte en søksmål fra tidligere president Trump, etter at hans sosiale medier-kontoer ble suspendert etter opprøret 6. januar. Meta vedgår ikke å ha gjort noe galt, men Zuckerberg er åpenbart ganske interessert i å bedre forholdet til Trump. Er vi egentlig vitne til en form for korrupsjon i den digitale sfæren?

🌟 Annet

- Trump går til krig mot elbiler og undergraver effektivt den amerikanske bilindustriens muligheter til å konkurrere. Kan gå begge veier for Tesla.